IA et vie privée

Master 2 : Smart City et gouvernance de la donnée

Victor VILA

Au programme :

- 14h00 - Présentations

- 14h15 - Objectifs

- 14h20 - Introduction : l'IA

- 15h00 - Le projet

- 15h15 - Le marché public

- 15h30 - Les données de test

- 16h00 - Le registre

- 16h15 - Pause café

- 16h30 - Le lancement de l'application

- 16h45 - La boîte noire

- 17h00 - Le piratage

- 17h15 - Le biais

- 17h30 - Déclaration algorithme

- 17h45 - Récap & Retours

Objectifs :

- Comprendre le fonctionnement des IA dans ses grandes lignes

- Identifier ses impacts sur la vie privée

- Appliquer ces connaissances dans le cadre d'un projet

Ce cours n'est pas :

Une compilation de la législation autour de l'IA

Un cours de programmation

Introduction : l'intelligence artificielle

Présentation des concepts de base de l'IA à l'intention des profils non techniques.

Présentation

IA : démêler le vrai du faux

Bienvenue à l'équipe Smart City

Vous travaillez au sein de la mission Smart City d'une grande ville.

Les défis auxquels vous ferez face aujourd'hui sont nombreux et nécessitent de beaucoup de réactivité pour tenir les délais.

Commençons !

Le projet

Le conseil municipal, fraîchement élu, souhaite se lancer dans un projet qui puisse donner à la ville une image plus moderne et attractive.

Pour cela, on vous confie la tâche d'imaginer et de mettre en place ce projet.

Vous avez une grande liberté dans le choix du projet, mais il y a tout de même une contrainte : il faut que votre idée fasse appel aux dernières technologies et en particulier à l'intelligence artificielle. Pas de problème, vous êtes au fait de ce que les IA peuvent faire.

De plus, souhaitant que ce projet rende service aux habitants de la ville, vous n'hésitez pas à traiter des données à caractère personnel.

Travail en équipe

Le conseil municipal vous pose ces questions :

- Quel problème résout votre projet ?

- Quelles données à caractère personnel utilise-t-il ?

- Comment l’intelligence artificielle utilise ces données ?

L'un des conseillers municipaux rappelle le scandale de Target il y a quelques années

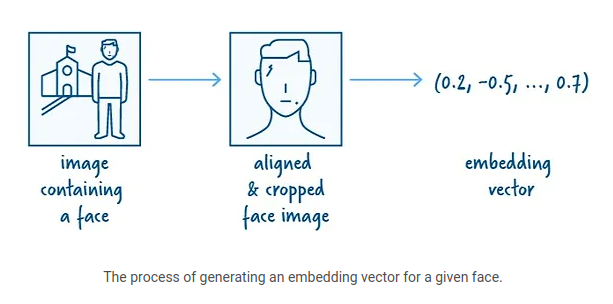

Clearview AI

Moteur de recherche d'identification d'individus à partir de photographies.

30+ milliards d'images collectées (y compris enfants).

Amende de 20M€ par la CNIL en octobre 2022

Image : t3n.de

Crédits images : https://www.clearview.ai/post/how-we-store-and-search-30-billion-faces

Les images de Google Street View de votre maison peuvent prédire votre risque d'accident de voiture

Les images de Google Street View de votre maison peuvent prédire votre risque d'accident de voiture.

Cette découverte montre comment les données à caractère personnel peuvent être déduites de données à priori inofensives

Risques des IA pour la vie privée

Biais

IA manipulable, p.ex. Tay

Opacité (black box)

Limitation ou refus de droits, p.ex. assurance

Manipulation de personnes, p.ex. Cambridge Analytica

Désanonymisation (ré-identification)

Inférence d'information privée, p.ex. Target

Impact sur la vie privée des deep fakes

Non conformité au RGPD, p.ex. détournement de finalité

...

Le projet est approuvé !

La DPO vient tout juste de prendre connaissance du projet.

L'aviez-vous prévenue ?

Le marché public

Faute de compétences des ressources internes, les développements informatiques associés à votre projet seront confiés à un prestataire qui sera choisi dans le cadre d'un marché public.

La DPO frappe à votre porte et vous sollicite pour l'aider à définir les clauses qui encadreront cette sous-traitance.

Travail en équipe

- Listez les principales informations qui doivent contenir ces clauses

- Décrivez l'un des traitements de données à caractère personnel réalisés par l'IA tel qu'il apparaîtra dans l'avenant de sous-traitance

Les données de test

Le prestataire a besoin de données pour tester son algorithme et il vous les demande.

Que faîtes-vous ?

Le registre

Très impressionnée par votre performance avec les clauses du marché public, la DPO vous demande de l'aider à remplir le registre de traitements en ce qui concerne votre projet.

Concrètement elle vous demande de :

Travail en équipe

- Lister les traitements de données à caractère personnel de votre projet

- Renseigner les informations obligatoires des traitements réalisés par l'IA (finalité, durée, ...)

Le lancement de l'application

Les développements sont finis, votre application testée et mise en production.

Le conseil municipal vous félicite pour ce lancement longuement attendu qui placera votre ville parmi les fleurons du numérique national.

Mais ..., il se peut que quelqu'un ait oublié une démarche par rapport aux données à caractère personnel ...

Travail en équipe

- De quoi s'agit-il ?

- Identifiez les actions correctrices et son contenu

La boîte noire

Cette fois-ci est la bonne.

Vous avez la certitude que tout est rentré dans l'ordre et que le projet est parfaitement maîtrisé quand le téléphone sonne ... Encore un oubli ?

Le service de communication de la mairie vous signale que plusieurs citoyens sont en désaccord avec les décisions de l'intelligence artificielle et demandent à que quelqu'un leur explique comment ces décisions sont prises !

Présentation

Les black boxes

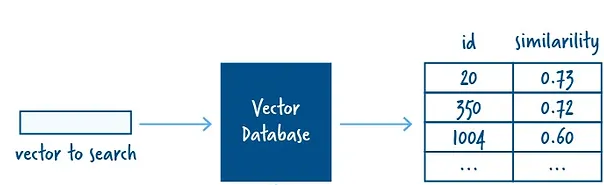

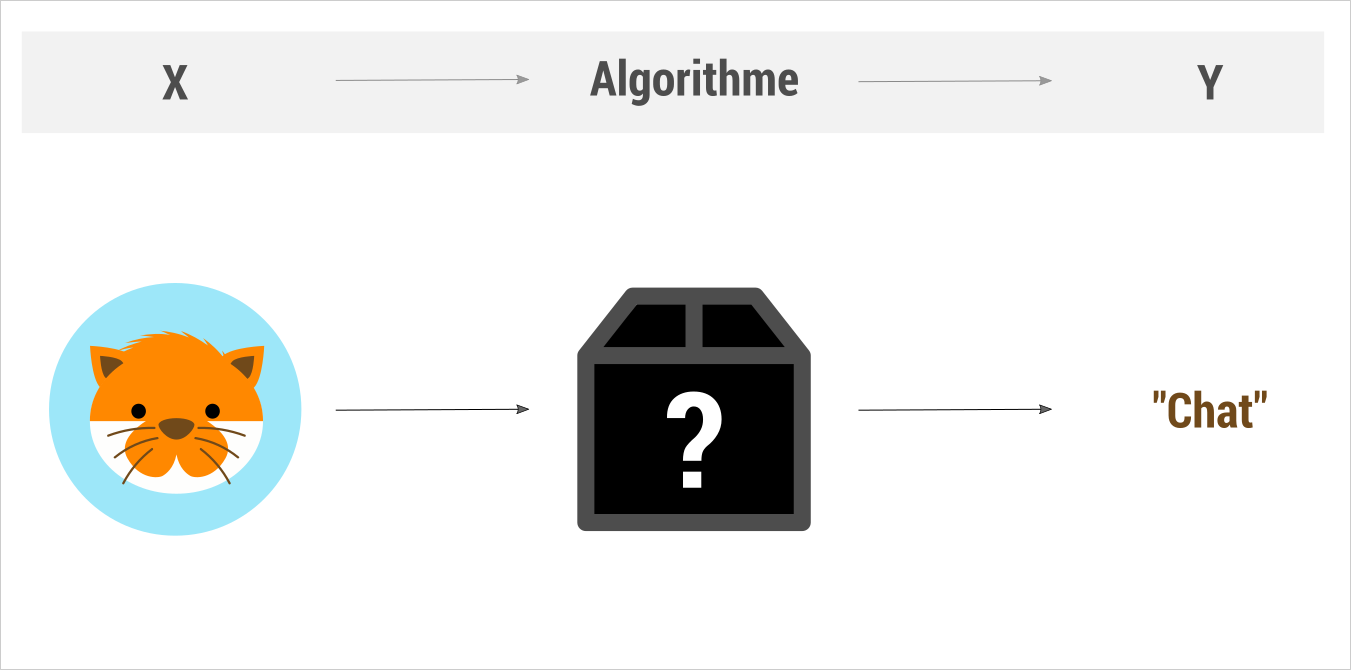

Rappel : l'algorithme

Rappel : l'algorithme

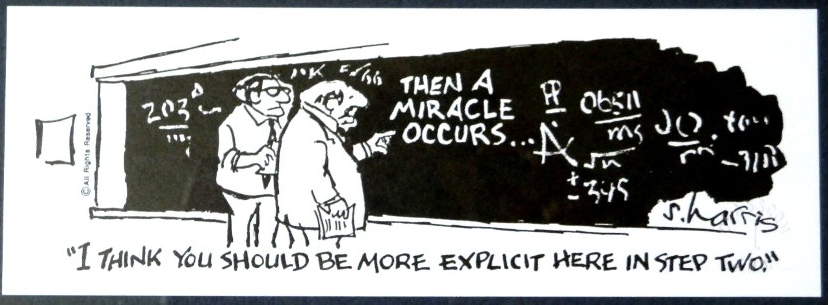

La boîte noire est un système algorithmique dont il est possible d’observer les données d’entrée (X), les données de sortie (Y) mais dont on comprend mal le fonctionnement interne

Pourquoi ?

Certains problèmes ne peuvent pas être résolus avec des règles pré-établies à l'avance (p.ex. reconnaissance d'images, transcription d'audio, etc).

Les techniques permettant de le faire comme le deep learning, basent leur apprentissage sur des calculs qui peuvent mobiliser des millions de paramètres, ce qui provoque l’incapacité à décrire de façon intelligible le résultat produit sur chaque nouveau cas.

Comment "voit" une image un réseau neuronal ?

L’explicabilité : impact sur la vie privée

En tant que société, on ne peut admettre que certaines décisions importantes puissent être prises sans explication.

Accepteriez-vous des décisions injustifiables dans des domaines aussi décisifs pour votre vie comme l’accès au crédit, à l’emploi, au logement, à la justice ou à la santé ?

Lorsque ces décisions automatisées s'appuient sur des données à caractère personnel on parle de profilage.

Le profilage

Toute forme de traitement automatisé de données à caractère personnel visant à évaluer les aspects personnels relatifs à une personne physique, notamment pour analyser ou prédire des aspects concernant le rendement au travail de la personne concernée, sa situation économique, sa santé, ses préférences ou centres d'intérêt personnels, sa fiabilité ou son comportement, ou sa localisation et ses déplacements, dès lors qu'il produit des effets juridiques concernant la personne en question ou qu'il l'affecte de façon similaire de manière significative.

La réaction du RGPD

Transparence des informations et des communications

Art. 12.1 RGPD Le responsable du traitement prend des mesures appropriées pour fournir toute information [...] d'une façon concise, transparente, compréhensible [...]

Décision individuelle automatisée, y compris le profilage

Art. 22.1 RGPD La personne concernée a le droit de ne pas faire l'objet d'une décision fondée exclusivement sur un traitement automatisé, y compris le profilage, produisant des effets juridiques la concernant ou l'affectant de manière significative de façon similaire.

Droit d'accès

Art. 15.1.h) RGPD l'existence d'une prise de décision automatisée, y compris un profilage, [...] des informations utiles concernant la logique sous-jacente, ainsi que l'importance et les conséquences prévues de ce traitement pour la personne concernée.

Le piratage

Après 6 mois d'exploitation de votre application, vous pensez qu'il est salutaire de faire auditer votre application par une société externe.

Trois semaines plus tard, les résultats de l'audit vous sont remis.

Votre application utilise des capteurs connectés en Wi-Fi au serveur central pour éviter les câbles. Cependant, le système utilise les codes d'accès d'usine qui n'ont pas été changés !

La faille a été utilisé par des hackers qui ont récupéré la base de données y compris les données à caractère personnel. Les données n'ont pas été rendues publiques et aucune demande de rançon n'a été formulée.

Travail en équipe

- S'agit-il d'une violation de données ?

- Déclarer à la CNIL ? Quelles sont les informations à consigner ?

- Communiquer aux personnes concernées ? Que faut-il leur dire ?

- Y-a-t-il des exceptions à cette communication ?

Casino hacké par l'aquarium

Un casino aux Etats-Unis a installé un aquarium dans le hall d'entrée. La connexion IoT de l'aquarium lui permettait de surveiller à distance la température, la salinité et d'automatiser les repas. Pour s'assurer que ces communications restent séparées du réseau commercial, le casino a configuré le réservoir pour qu'il utilise un VPN individuel afin d'isoler les données du réservoir.

Après quelque temps, la sécurité a remarqué que le réservoir avait envoyé environ 10 Go de données en Finlande concernant les clients du casino et leurs dettes. Le casino avait été piraté via l'aquarium.

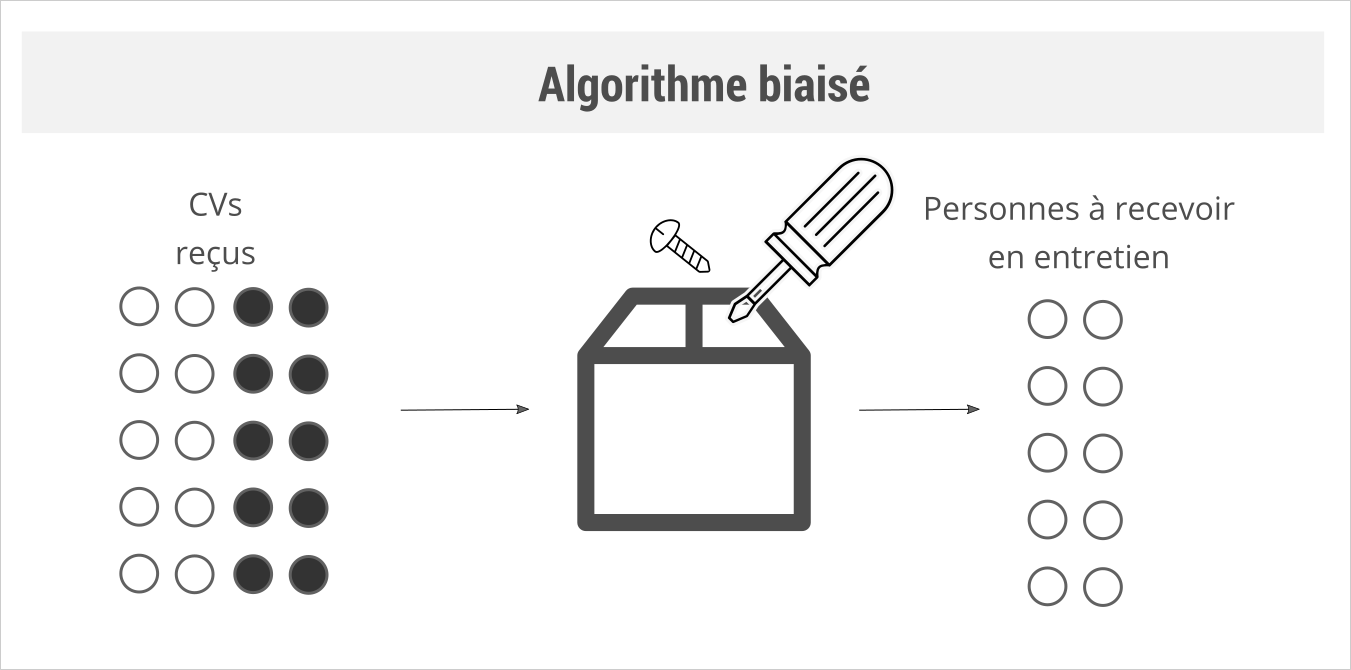

Le biais

Deux ans déjà !

Vous examinez les résultats de votre IA et vous remarquez que depuis un certain temps elle a tendance à favoriser un certain profil de citoyen. Cette tendance semble s'accentuer avec le temps.

Qu'est-ce qui se passe ?

Présentation

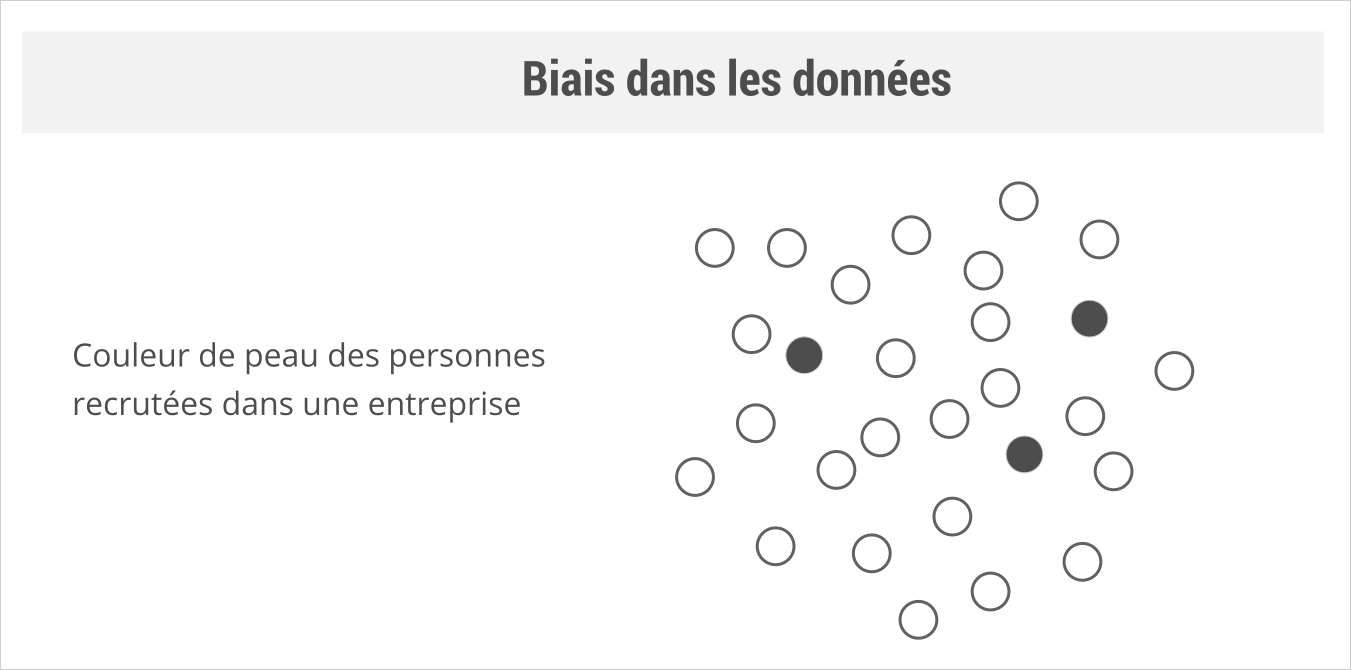

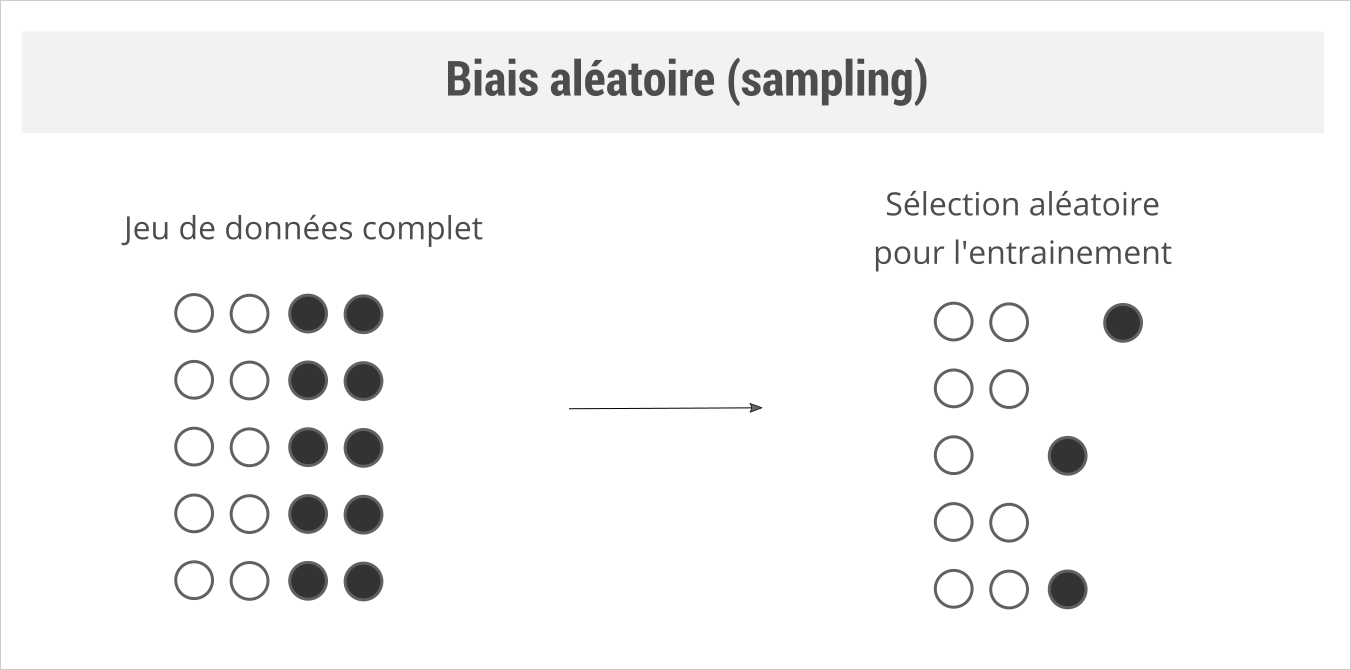

Les biais

Les IA peuvent être très utiles pour automatiser certaines tâches. Pour cela, elles s'appuient sur les relations qu'elles trouvent entre les données qui lui sont fournies pour les entrainer.

Si ces données ne sont pas neutres l'algorithme reproduira les discriminations déjà présentes dans les jeux de données qu’on lui fournit.

Types de biais

Amazon RH

Rêvant d'automatiser le processus de recrutement, Amazon a lancé un projet d'IA en 2014 basé sur l'examen des CV des candidats. En 2015, Amazon s'est rendu compte quel'IA ne notait pas les candidats de manière équitable et qu'il présentait des préjugés à l'égard des femmes.

Les données utilisées pour entrainer l'IA contenaient des préjugés contre les femmes car il y avait une domination masculine dans l'industrie technologique et les hommes formaient 60% des employés d'Amazon. Le système de recrutement d'Amazon a donc appris à tort que les candidats masculins étaient préférables. Il a pénalisé les CV comportant le mot "féminin", comme dans "capitaine du club d'échecs féminin". Amazon a donc cessé d'utiliser cette IA.

Biais et boîte noire

La problématique du biais peut être renforcée si l'algorithme est une boîte noire : dans ce cas, il n'est pas possible de savoir si le biais vient de l'algorithme lui-même ou des données.

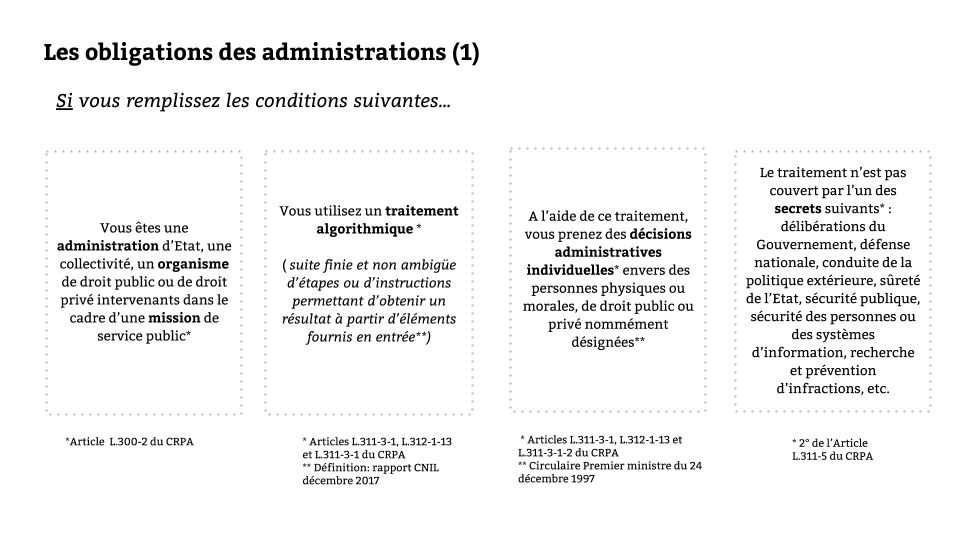

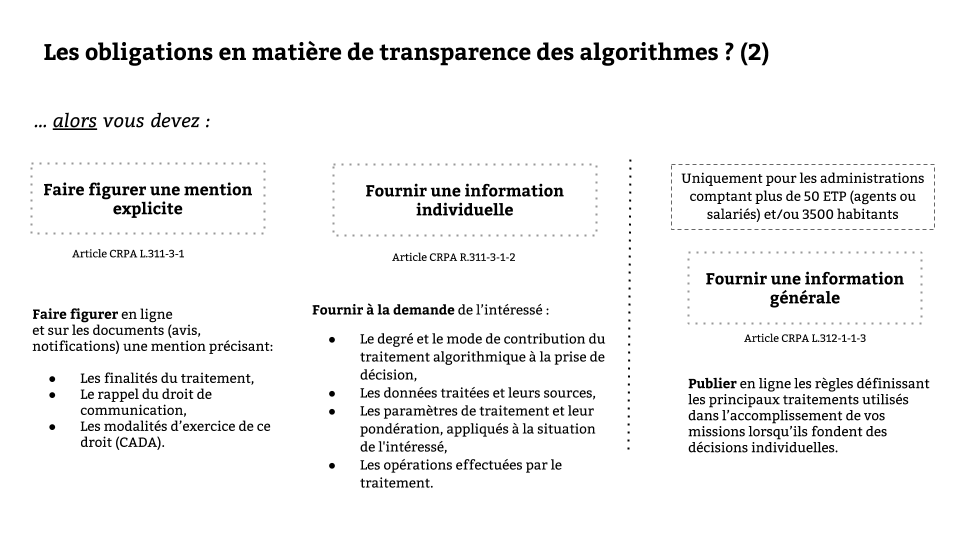

Déclarer son algorithme

Vous épluchez une newsletter de veille et vous découvrez un webinaire d'Etalab qui parle de l'obligation de déclarer ses algorithmes. Auriez-vous loupé quelque chose ?

Présentation

- Les obligations concernant les algorithmes

En synthèse ...

Travail en équipe

- Préparez une déclaration succincte de votre algorithme

- Inspiration : https://data.nantesmetropole.fr/pages/algorithmes_nantes_metropole/

Bravo !

Vous avez survécu à ce projet !

Analyse de nouveaux projets

Vous êtes victimes de votre succès et vous êtes reconnus comme experts des risques qu'un projet utilisant l'IA peut présenter via-à-vis de la vie privée. En conséquence, les demandes d'analyse ne cessent plus d'arriver sur votre bureau...

Présentation

Cas d'usage de l'IA dans le secteur public